2024.09.08

2024.09.08 8552

8552

9月6日,以“以AI守护AI,大模型时代的攻守之道”为主题的“2024lnclusion 外滩大会”见解论坛于上海成功举办。大会由蚂蚁集团、中国新一代人工智能发展战略研究院、云安全联盟大中华区、中国网络空间安全协会人工智能安全治理专委会联合主办,聚力探讨AI技术在确保大模型可靠、可控及安全性方面的创新应用。

在论坛期间,云安全联盟(CSA)大中华区发布《AI可信度分析》报告。报告由云安全联盟大中华区的多个成员单位,包括中国电信、西安电子科技大学、广州大学、蚂蚁集团、百度和天翼云等单位共同编制。

该报告结合相关标准,归纳整理AI模型可信度的定义及其评估方式,结合业界先进的AI可信度探索案例,提出了提高AI模型可信度的策略建议,并对未来AI模型可信度的发展趋势、潜在的技术与市场机会进行展望,希望为政策制定者、行业从业者以及研究人员提供有价值的参考。

AI可信度的定义

报告认为,AI可信度的定义是:无论从技术层面还是社会层面,AI在执行任务时均能够赢得用户的信任和接受的程度。具体地,一个高可信度的AI应包含两个组成部分,这些组成部分应贯穿于系统的整个生命周期。从技术层面来看,可信AI应同时具备如下属性:准确性、可靠性、安全性 、稳健性、可解释性;从社会层面来看,可信AI应同时具备如下属性:隐私性 、合规性 、公平性 、伦理和社会影响。

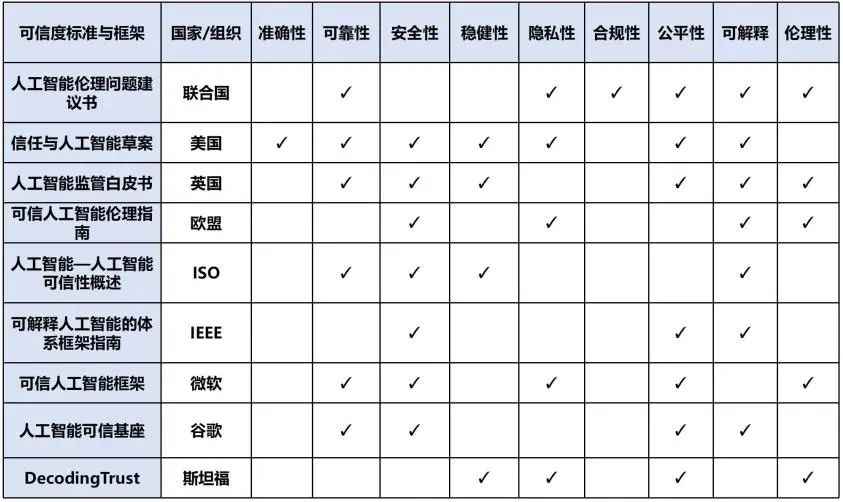

按照上述定义,报告梳理出目前已存在的可信度标准与框架情况,部分可信度标准与框架及其覆盖内容的对照情况如下表所示。

可信度标准与框架对照表

迅猛发展的AI技术引发信任危机

工信部统计数据显示,截至2023年6月,我国AI核心产业规模已达5000亿元,AI企业数量超过4400家,仅次于美国,全球排名第二。如今,AI已作为一项关键的革命性技术,在医疗、教育、交通等领域广泛应用,不断推进人类生产力发展,改善人们的生活方式。

- AI的训练数据导致决策偏见;

- AI算法存在脆弱性,容易引发模型幻觉,给出错误的信息;

- AI容易受到数据投毒等针对性攻击,致使模型给出错误的判断,甚至输出错误的意识形态;

- AI可解释性较差,算法不透明;

- AI决策导致安全事故时的责任主体难以界定;

- AI模型决策导致安全事故时的责任主体难以界定。

AI可信度评估方法

1数据质量及处理方法

2模型设计与开发过程

在模型设计与开发过程中,需综合考虑模型的鲁棒性、公平性、安全性、可解释性和伦理性。通过在模型设计阶段引入对抗性训练、防御机制等手段,增强模型在不同环境下的稳定性和安全性。在开发过程中,确保数据和模型决策的透明性和公平性,避免偏见的产生。

3模型可信度测试与验证方法

模型的可信度测试和验证是确保其实际应用可靠的关键步骤。测试包括对模型性能、公平性、安全性和可解释性的评估。通过使用不同的测试集和对抗样本,检验模型在处理未知数据或恶意输入时的表现,确保其在动态环境下保持稳定。

4持续监控与反馈机制

AI系统的可信度不仅依赖于开发阶段的设计和测试,还需要在实际运行中持续监控和改进。通过对模型的预测准确性、数据漂移、异常情况和资源使用进行实时监控,可以及时发现潜在问题。此外,建立完善的反馈机制,通过用户反馈、专家评审等方式,持续优化模型,确保AI系统始终保持高水平的可信度和用户满意度。

提高AI可信度的策略与实践

报告指出,AI可信度可从政策法规的规范化制定、完善监督制度、推动行业可信赖生态建设、建设行业标准、加强专业人员培训以及提升普通公民素养等方面实现综合的提升。

全球和国家层面的政策法规为AI技术的开发与应用提供了明确的法律框架, 而完善的监督制度是确保AI可信度的关键。通过分级分层的监管体系,监督AI在全生命周期中的行为,包括开发、测试、评估、部署等环节。监督制度的建设可以有效防范AI应用中的风险,确保AI技术的透明性和可追溯性,并通过实时的风险管理机制减少潜在的负面影响。

此外,构建行业内部的协作生态,鼓励企业、研究机构和监管部门之间的合作,以实现AI的技术可解释性、公平性和透明性。同时,加快推进AI标准的制定,推动行业内可信技术的落地,确保AI技术能够在实际应用中安全可靠。

加强专业人员培训也是提升AI可信度的重要方面。通过系统的教育和培训,培养具备技术、安全和伦理素养的AI专业人才,如CSA推出的CAISP认证,帮助从业者掌握应对AI安全挑战的能力。

AI可信度研究需与时俱进、持续发展

AI可信技术一方面有利于模型性能的全面提高,是模型能更好地满足应用场景的实际需求,另一方面也有助于跋扈公众利益,规范行业行为,降低法律和伦理风险,促进社会公平和公正。随着AI技术的不断发展及广泛应用,AI可信性在政策制定、技术创新两方面必将持续发展。

潜在的技术与市场机会

01技术机会方面,包括:

- 模型鲁棒性增强:通过对抗训练、数据增强、多模态数据融合提升模型在复杂环境中的稳定性和适应能力。

- 可解释性技术:开发可视化工具、规则提取和因果推理技术,增强模型的透明度,帮助用户理解模型决策。

- 验证与评测工具:标准化性能测试、安全性评估工具,确保AI模型的高性能和可靠性。

- 数据要素管理:确保数据质量,使用自动化标注和隐私保护技术,如联邦学习和差分隐私,提升数据安全。

- AI可信管理:构建AI治理框架、风险评估与控制机制,确保AI在法律、伦理和技术层面上的合规性。

02市场机会方面,包括:

- 工业应用:通过可信AI进行预测性维护和智能质量控制,提升生产系统的可靠性和效率。

- 金融服务:提高信用评分透明度和反欺诈检测,增强客户信任。

- 医疗保健:可信AI应用于医疗影像分析和个性化治疗方案,提升医疗决策的透明性和准确性。

- 智能交通:在自动驾驶和交通管理中提供可信的决策解释,增强用户对智能交通系统的信任。

- 公共服务:通过公共安全监控和智慧城市规划,提高政府的透明度和公信力。

- 数据要素市场:可信AI帮助建立安全的交易平台,提供高质量数据服务,确保数据合规性。

- AI可信管理服务市场:提供AI合规咨询、风险管理和伦理审查等服务,满足企业对AI可信性的需求。

总结

致谢

《AI可信度分析》白皮书由CSA大中华区AI模型可信度研究项目组专家和外部专家联合指导撰写,感谢以下专家的贡献:

组长:

高毅昂

专家组:

黄连金、王维强、黄磊、黄挺、杨大伟、王皓、闫峥、李默涵、闫斐、崔世文、包沉浮、林琳

编委会:

田毓嘉、游丽娜、闫泰毓、王杰、陈鹏、唐可可、白佳奇、胥迤潇、刘刚、李红程、高磊、郭建领

校验组:

吕鹂啸、万米迪、陈周建、伍超敏、方先行、杨维彬、方旭辉、王佳楠、田佳琦、勒洮、蔡逆水、罗智杰、王彦婷、钟良志、卜宋博、姜禹尧、温恒睿、顾炘宇、刘腾飞、闭俊林

贡献单位:

中国电信集团有限公司、云网基础设施安全国家工程研究中心、西安电子科技大学、广州大学网络空间安全学院、蚂蚁科技集团股份有限公司、北京百度网讯科技有限公司、天翼云科技有限公司

(以上排名不分先后)

本文作者:

李默涵,广州大学教授

陈鹏,广州大学博士后

登录

登录 首页

首页 会员

会员 活动

活动 研究

研究 培训

培训 评测认证

评测认证 解决方案

解决方案 关于我们

关于我们