2024.07.24

2024.07.24 5485

5485

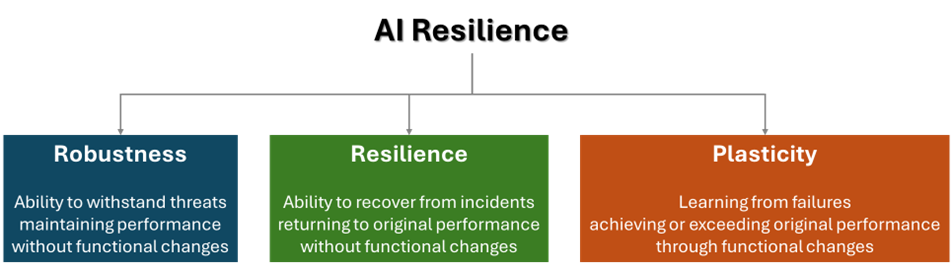

韧性经常被作为一个流行词信手拈来,但它的真正定义是什么可能相当难以捉摸。在这篇博客中,我将探讨AI韧性的三大支柱:稳健性、韧性和可塑性。虽然稳健性和韧性对AI安全至关重要,但我将重点探讨可塑性——它既提供了令人难以置信的机遇,也带来了重大风险。此外,我还将着重阐述将多样性融入AI系统如何能加强AI领域,并为未来的挑战提供更坚韧的框架。

在我们深入探讨这方面的潜在的积极成果和可能引发的担忧之前,让我们首先了解一下稳健性和韧性。这两个支柱是AI安全性和可信度的基础:

稳健性是指AI系统在不影响其性能或改变其功能的情况下抵御威胁的能力。若要增强AI稳健性,需要先了解各种威胁的途径,这些途径在简单的ML应用程序以及复杂的LLM或GenAI系统之间有着显著的差异。虽然一流的网络安全至关重要,但每个应用程序都有其独特的风险。云安全联盟(CSA)最近发布了一份全面的LLM威胁分类,提供了有价值的见解[1]。

韧性是指AI系统在不改变其功能的前提下,从影响其性能的事故中恢复的能力。AI的韧性取决于其受到影响的严重程度和频率。只要这两个因素保持在一个联动的关键阈值以下,系统就可以反弹并恢复到以前的运行状态。可以按照二维的方式来构想韧性。

图1表明了AI韧性的三大支柱。CSA把这个概念和一种新型基准测试方法进行结合,在2024年RSA会议期间发表的白皮书《AI韧性:AI安全的革命性基准模型》[2]中进行了探讨。

图一:AI韧性

可塑性是指,AI在失败后不仅能够恢复到以前的表现水平,而且有可能超过它原有水平的能力——尽管功能会发生变化。在人类世界,这种能力被称为神经可塑性,它允许大脑改动或形成新的神经通路,来战胜日常生活中的困难。当医生谈论脑损伤后的“完全康复”时,他们指的是功能恢复,而不是回到最原始的大脑布局。同样,可塑性能够让AI适应新的环境,并从失败中学习,以达到或超过它自身的性能基准。可塑性是一个多维度的概念。

AI韧性:一把锋利的双刃剑

在网络安全领域的攻击性安全领域中,AI代理的使用开始受到关注。AI代理是一种软件实体,它能够感知环境,执行任务,采取行动并独立做出决策,通常还结合了随时间推移的学习和适应的能力,以实现特定目标。AI代理的关键点包括:

自主性:它在没有直接人为干预的情况下运行,根据其编程方法和学习到的经验做出自己的决策,并采取行动。

感知:它通过传感器、数据输入或自主数据采集来收集信息,以了解其环境。

行动:它在其指定的环境中采取行动以实现特定目标,范围包括从简单的指令到复杂的操作。

学习和适应:它从经验中学习并随着时间的推移而提高性能,并且可能会改变其代码或算法。

目标导向行为:它旨在实现特定目的或目标,以指导其决策流程。

交互性:它与其他代理、人类或系统交互,以执行协作任务或提供服务。

网络安全专家经常强调,问题并不在于企业是否会被成功攻击,而是何时会发生。进攻性的安全措施有助于防止灾难性的网络攻击。然而,AI代理不仅仅是网络安全团队的工具——坏人也同样在使用它们,而这些人并不关心道德、公平或隐私。通过一些恶意调整,AI代理可以造成难以想象的破坏。虽然AI代理可以保护我们最有价值的资产,但也有可能摧毁它们。

AI韧性必须基于多样性

标准化和法规推动了数字世界和运营技术的自动化,国际标准促进了贸易和灾难恢复。例如,1904年的“巴尔的摩大火”(Great Baltimore Fire)推动了消防栓的标准化,突显了标准和法规的关键作用。

另一方面,标准会通过统一的漏洞造成集中的风险,使得黑客更容易更快速地入侵遵循同一标准的系统。在关键基础设施中,标准可以挽救生命,但也可能带来重大风险。那么,我们应该在哪里划定界限呢?

自然界提供了一个成功的折中方案:自然界中某些特征是高度标准化的,例如DNA(人类和猪的遗传物质有98%都是共通的),但允许通过表观遗传学(epigenetics)进行调整,并根据环境通过选择性的蛋白质表达(selective protein expression)来进行个体微调。

大自然给我们的经验是明确的,我们需要迅速学习:标准化关键接口,但允许为特定国家、特定组织,甚至是个人的解决方案留出创新空间,以实现相同的目标。当前如SEC、NIS2和DORA这样的立法都制定得相当模糊,但就各自目的而言均具有约束力。至关重要的是,这种灵活性允许多样化和独特的解决方案并存。只有基于多样性且各有优劣的方法,才能在我们快速发展的数字世界中实现长期稳定。

采取多样性可能不是应对新兴挑战的最廉价或最快,但却是唯一有潜力的方法,能够成功应对迫在眉睫的威胁。这一策略还强调了超越常规的创造性解决方案的必要性。

您可以在CSA年度SECtember会议上进一步扩展您的AI知识。今年,我们将深入探讨云安全和生成式AI之间的交集。

2024年9月10日至12日举行的SECtember.ai 分会场将邀请行业创新者提供关键工具和最佳实践,以满足我们这个时代最重要技术的快速发展需求。点击此处了解更多关于会议的信息。

参考资料

[1]大语言模型(LLM)威胁分类,CSA,2024年6月

[2]AI韧性:AI安全的革命性基准模型,CSA,2024年5月

[3]巴尔的摩大火,在线资源,访问时间:2024年6月16日。

文章来源:

AI Resilience & Diversity | Strengthen AI Systems | CSA (cloudsecurityalliance.org)

本文翻译来自CSA翻译组:

翻译:Walmart Kevin Wang,CSA大中华区专家

审校:苏泰泉,CSA翻译组轮席组长

登录

登录 首页

首页 会员

会员 活动

活动 研究

研究 培训

培训 评测认证

评测认证 解决方案

解决方案 关于我们

关于我们