2025.05.08

2025.05.08 5817

5817

在生成式 AI 热潮席卷全球之际,企业若想把握创新红利,首先要守住治理、风险与合规(GRC)底线。云安全联盟(CSA)大中华区发布的《 AI 组织责任:治理、风险管理、合规与文化方面 》正是业界首份从组织职责维度系统阐述 AI GRC 的权威指南,为 CISO、CIO、CTO 乃至董事会提供了一张“施工图”与“检查表”。白皮书将勾勒落地路径,来助力企业在数字化丛林中构筑属于自己的安全护城河。

六大跨维视角,掌握 AI 项目成败关键

白皮书开篇给出了一个极具参考价值的“六维透镜”模型,从评估标准、RACI 模型、高级实施策略、持续监控与报告、访问控制、适用的框架与法规六个方面,对每一项责任进行统一拆解,真正做到了“既给框架,也给标尺”。

1.评估标准:通过量化的指标,帮助利益相关者衡量法规合规性、风险暴露情况,并与组织政策对齐,以确保AI技术中的GRC实践。

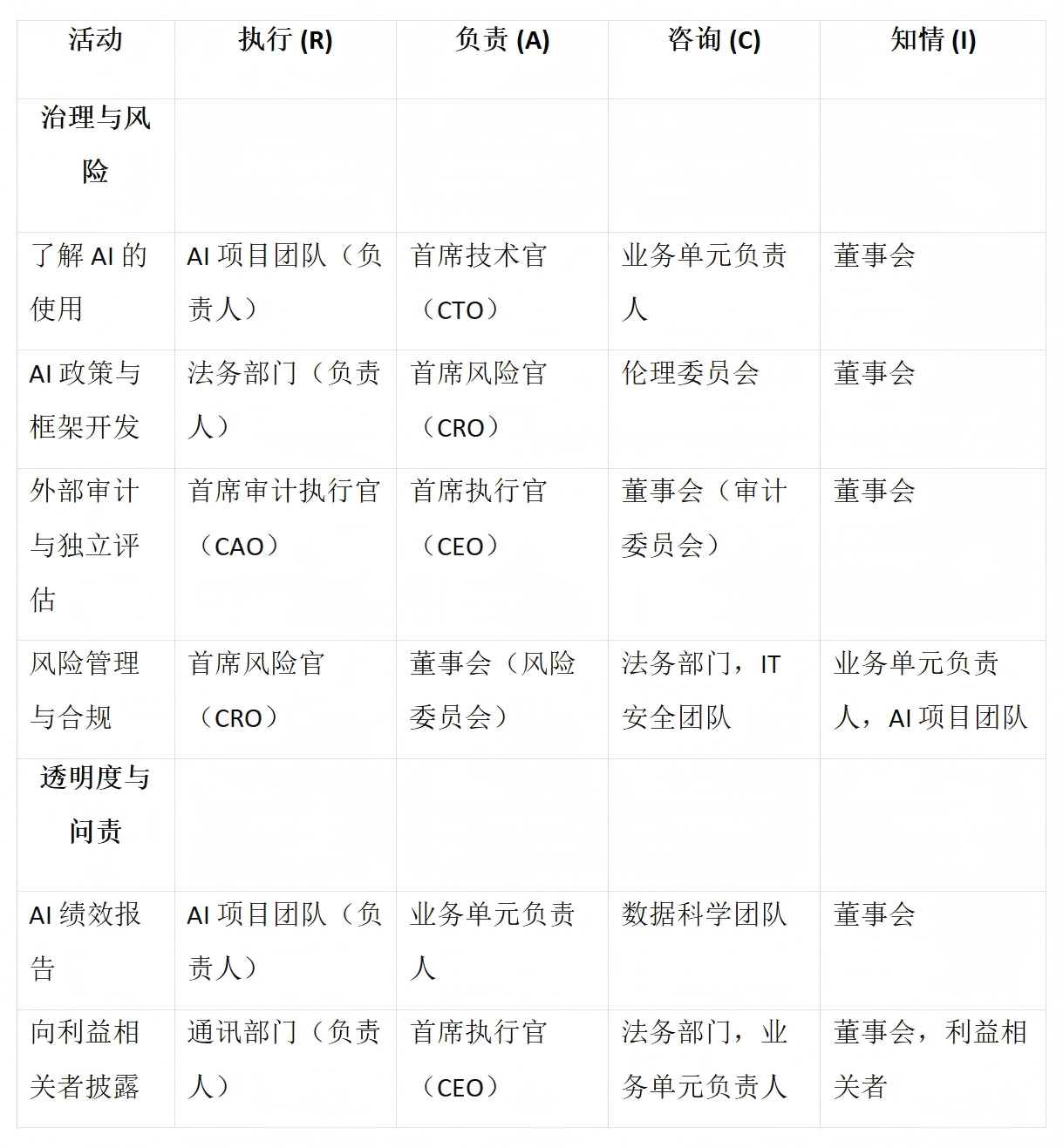

2.RACI 模型:执行、负责、咨询和知情(RACI)模型为任务、里程碑和GRC相关过程的可交付成果定义了角色和责任的结构化框架。此模型确保在整个AI生命周期中角色和责任的透明性和问责制。

3.高级实施策略:说明GRC责任如何在组织层面实施,以及为成功采用需要克服的障碍。

4.持续监控与报告:持续的监控与报告机制对于保持AI系统中GRC的完整性至关重要。实时跟踪、合规性问题警报、审计轨迹等有助于识别安全事件,并为及时解决GRC相关问题提供支持。

5.访问控制:有效管理模型注册表、数据存储库和适当的访问权限有助于缓解与未经授权访问或滥用AI资源相关的风险。通过实施健壮的访问控制机制,组织可以保护敏感数据并确保遵守监管要求。

6.适用的框架与法规:遵守行业标准(如ISO/IEC 27001、国家标准与技术研究所(NIST)指南及法规,如欧盟(EU)AI法案)有助于确保AI项目与已建立的GRC实践对齐,维护组织价值观、责任和法规义务。

责任落脚点一:风险管理,从“威胁建模→数据漂移”闭环

在 GRC(治理、风险与合规)的三大核心领域中,“风险”通常是推动治理与合规投入的起点。白皮书专门用了一整章来详细剖析八个关键的风险管理环节:威胁建模、风险评估、事件响应、运营弹性、审计日志、风险缓解以及数据漂移监控。每个环节都配套了量化指标和示例关键风险指标(KRI);例如在攻击模拟部分,文中列出了数据投毒、对抗样本、模型反演、绕过检测这四类典型场景,并给出了“模拟→缓解”的动作清单。

这些内容为 DevSecOps、红蓝对抗团队乃至法务合规提供了可直接复用的“剧本模板”,让风险评估不再停留在 PPT,而是能够进入持续演练与指标跟踪的工程化阶段。

责任落脚点二:治理与合规,让董事会读得懂 AI 风险

白皮书把“治理与合规” 置于第二章核心位置,并特别强调了董事会视角的报告机制。其中一张 RACI 表对“AI 政策制定、独立审计、外部披露”等关键活动的责权分配做了清晰映射:

- 执行(Responsible):AI 项目组 / 法务 / 内审

- 负责(Accountable):首席执行官(CEO)/ 首席风险官(CRO)/ 首席审计官(CAO)

- 咨询(Consulted):伦理委员会 / IT 安全 / 业务单元

- 知情(Informed):董事会及利益相关方

这张表帮助组织厘清“谁来拍板、谁来执行、谁需旁听”,为 AI 治理提供了透明的沟通通道。

同时,白皮书给出了一套面向董事会的季度 AI 报告指标,覆盖治理覆盖率、模型可解释性分数、安全事件均值恢复时间(MTTR)等维度。把这些指标嵌入现有 ESG 或信息安全 KPI,看板就能“一屏呈现”AI 治理温度计。

责任落脚点三:安全文化 & Shadow AI,攻守皆在“人”

技术只是冰山一角,真正决定 AI 项目成败的是组织文化。第三、四章给出了角色分级培训 → Shadow AI 清点 → 缺口分析 → 未授权检测 → 变更管控的闭环路线。特别是 Shadow AI 部分,白皮书通过 AI 清单系统、访问控制与持续审计三条主线,将“技术资产台账”理念延伸到模型、数据与推理服务,让 IT AM 与 MLOps 在同一张资产清单上对齐口径。

一旦形成“人人有责、事事可追”氛围,员工在引入第三方模型或自行训练脚本时,便会自发对照清单与流程,大幅降低隐性合规风险。

三步走,把白皮书变成企业 GRC 的“可执行契约”

1.对标六维模型,做一次 360° 现况体检

以白皮书提出的六维透镜为标尺,组建横跨安全、法务、业务的快速评估小组,针对当前所有 AI 项目进行逐条映射与打分,输出一份缺口矩阵与优先级清单,明确“先堵哪一环、先补哪一策”。

2.权责落地

依据评估结果,调用白皮书附录中的 RACI 模型模板,把每条责任分解到岗、签字确认,并写入现有治理流程与 OKR 体系;同时为各角色设定可量化的 KRI/KPI,如模型可解释性得分、数据漂移告警关闭时长等,实现自顶向下的问责与自下而上的度量。

3.以 KRIs/OKRs 为牵引,构建可视化治理看板

选取白皮书推荐的核心度量指标,接入现有 BI 或 SIEM 平台,构建实时可视化治理仪表盘;再通过季度审计 + 事后复盘双循环,持续校准指标阈值与改进路径。三个动作环环相扣:体检告诉你差距,权责确保有人兑现,指标倒逼持续优化,如此才能把一份纸面的最佳实践,真正转化为可追踪、可审计、可复用的企业级 GRC 契约。

综上,白皮书以“六维透镜”贯通风险管理、治理合规、安全文化与 Shadow AI 防控等核心议题,为 AI 系统建立了可量化指标体系、RACI 责权矩阵及持续监测机制。企业可据此快速完成现状评估、策略落地与可视化管控闭环,确保模型全生命周期的安全、稳健与符规运行,为后续扩展至供应链和行业法规奠定统一技术基线。此外,其对数据漂移监测、攻防演练、日志审计等子域给出了操作性模板与参考标准,便于团队在现有 DevSecOps 流水线中平滑集成,实现自动化、闭环治理。

致谢

本文作者:

卜宋博 , CSA大中华区研究协调员

登录

登录 首页

首页 会员

会员 活动

活动 研究

研究 培训

培训 评测认证

评测认证 解决方案

解决方案 关于我们

关于我们