2025.02.14

2025.02.14 6548

6548

2月27日,AI Action Summit 在香港的分会场-人工智能安全、可信与负责任论坛(AI STR论坛)将在香港数码港召开!

本文深入剖析了 DeepSeek 的技术创新及其对网络安全的深远影响。文章首先介绍了 DeepSeek 的核心创新,包括其独特的组相对策略优化(GRPO)方法、DeepSeek V3 的多头潜注意力(MLA)和多令牌预测(MTP)技术。通过与 OpenAI 的对比分析,揭示了 DeepSeek 在训练方法、模型架构和成本效益上的差异化优势。同时,文章探讨了 DeepSeek 的开源策略及其在网络安全领域的双重影响,分析了模型托管的云环境和供应链风险,以及边缘 AI 部署对安全的挑战。最后,结合当前生成式 AI 的安全现状,提出了针对大模型公司的安全体系构建建议,旨在为行业提供应对技术发展与安全风险的参考框架。

DeepSeek 的主要创新

DeepSeek 作为人工智能领域的新兴力量,带来了一系列创新,推动了大型语言模型(LLM)的发展。其核心创新,区别于传统模型如OpenAI的GPT系列,主要体现在训练方法、模型架构和效率优化上。这些创新不仅提升了模型性能,还降低了训练成本,为更广泛的应用场景提供了可能。DeepSeek 论文 (DeepSeek-AI, 2025) 介绍了两个主要模型:DeepSeek-R1-Zero 和 DeepSeek-R1。

从基础模型开始的强化学习 (DeepSeek-R1-Zero):一项关键创新是 DeepSeek-R1-Zero 的开发,该模型使用大规模强化学习 (RL) 进行训练,没有将监督微调 (SFT) 作为预备步骤。这与许多其他 LLM 训练方法有很大不同。论文强调,DeepSeek-R1-Zero 通过纯粹的 RL “自然地展现出许多强大而有趣的推理行为” (p. 3)。这表明 LLM 有潜力在不依赖大量监督数据的情况下发展推理能力。

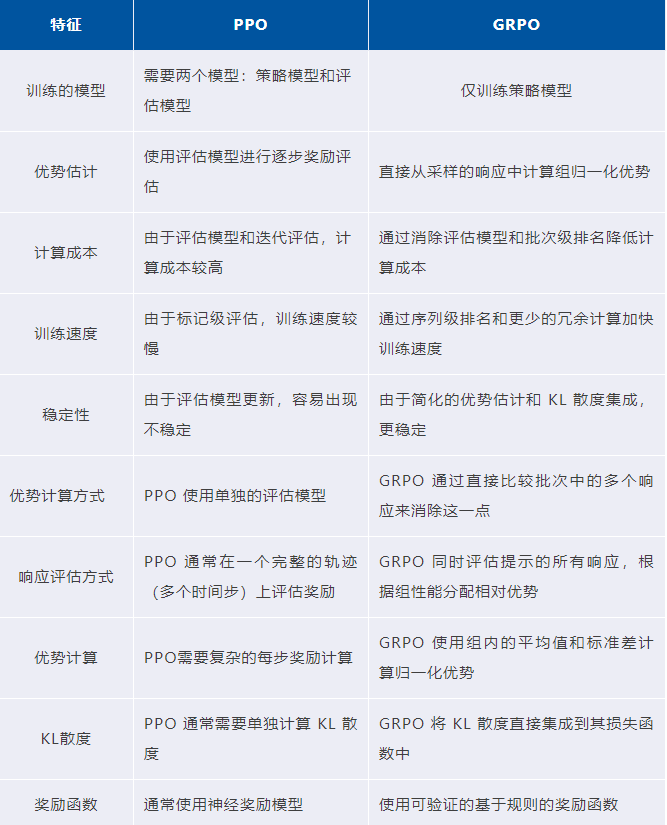

组相对策略优化 (GRPO):DeepSeek 利用 GRPO 作为其 RL 框架。GRPO 被认为是比近端策略优化 (PPO) 等传统方法更有效的替代方案。GRPO 的关键优势在于它消除了对单独的“评估”模型(critic)的需求。相反,GRPO 从组分数中估计基线,从而减少了计算与内存开销 (p. 5)。论文提供了 GRPO 目标函数的数学公式。

多阶段训练 (DeepSeek-R1):虽然 DeepSeek-R1-Zero 使用纯 RL,但 DeepSeek-R1 采用了多阶段训练流程。该流程包括:

- 冷启动: 在 RL 开始之前,使用少量高质量的思维链 (CoT) 数据对基础模型 (DeepSeek-V3-Base) 进行微调。这有助于减轻早期 RL 训练的不稳定性 (p. 9)。

- 面向推理的RL: 与 DeepSeek-R1-Zero 类似,此阶段使用 RL 和基于规则的奖励系统来专注于提高推理能力。

- 拒绝采样和监督微调: 在面向推理的 RL 之后,使用从 RL 检查点进行拒绝采样来创建新的 SFT 数据集。该数据集与其他领域的监督数据(写作、事实问答等)相结合。

- 所有场景的强化学习: 执行最后的 RL 阶段,重点关注推理和一般的有用性/无害性 (p. 11)。

基于规则的奖励建模: 论文强调了使用基于规则的奖励系统来训练 DeepSeek-R1-Zero。该系统侧重于两种主要类型的奖励:

- 准确性奖励: 这些奖励评估模型的响应是否正确。

- 格式奖励: 这些奖励强制执行特定的格式要求 (p. 6)。

作者特别避免使用神经奖励模型。

涌现的推理行为: 论文强调,DeepSeek-R1-Zero 通过纯 RL 训练,展现出“许多强大而有趣的推理行为” (p. 3)。这些行为,如自我验证和反思,在训练过程中自然出现。论文描述了一个“啊哈时刻”,模型在其中学会了重新评估其初始方法 (p. 8)。

蒸馏到较小的模型: DeepSeek 表明,较大的 DeepSeek-R1 模型学习到的推理能力可以有效地蒸馏到较小的密集模型中 (p. 11)。

多头潜注意力 (MLA) 和多令牌预测 (MTP) (DeepSeek V3): 虽然在DeepSeek R1 论文中没有详细描述,但其他来源表明 DeepSeek V3 使用了这些技术。

- 多头潜注意力 (MLA): MLA 优化了注意力机制。DeepSeek AI

- 多令牌预测 (MTP): MTP 允许模型并行生成多个 token

- 专家混合 (MoE): DeepSeek V3 采用 MoE 框架。

- 效率改进: MLA 和 MTP 的结合使 DeepSeek V3 能够以更低的训练和推理成本实现强大的性能。

深入探讨 GRPO

组相对策略优化 (Group Relative Policy Optimization, GRPO) 是 DeepSeek 强化学习方法的核心。

GRPO 的效率提升

1. 消除价值模型

GRPO (Group Relative Policy Optimization) 不依赖传统强化学习中的价值模型,而是通过组内奖励比较直接估计优势函数。这种方法大幅降低了计算成本,使得大规模强化学习训练更加高效。

2. 批次级奖励比较

GRPO 利用组内的相对奖励分数进行比较,通过对同一问题生成多条候选答案,计算这些答案的相对优势值,从而优化策略。这种机制减少了对绝对奖励的依赖,更适合开放性推理任务。

3. 序列级优势估计

相较于传统方法逐步计算奖励,GRPO 在整个序列级别上估计优势值,进一步提高了训练效率和模型性能。

4. 基于规则的奖励函数

在具体应用中,例如 DeepSeek,GRPO 结合了可验证的基于规则的奖励函数,确保了输出质量与任务需求的一致性。

GRPO 的主要优势

1. 提高样本效率

GRPO 更有效地利用每个样本,通过组内比较机制减少了对单独价值网络的依赖,从而显著提升样本利用率。

2. 训练稳定性

通过直接在损失函数中引入 KL 散度正则化,GRPO 避免了策略更新过大的风险,确保训练过程稳定且一致。

3. 成本效益

由于不需要额外的价值网络和复杂的计算,GRPO 显著降低了内存占用和计算开销,使其在大语言模型(LLMs)的训练中更具成本效益。

GRPO与PPO的比较

Proximal Policy Optimization (PPO) 是一种广泛应用的强化学习算法,由 OpenAI 于 2017 年提出,旨在通过限制策略更新的幅度来提高训练的稳定性和效率。PPO 属于策略梯度方法的范畴,它通过引入裁剪机制限制新策略与旧策略之间的变化幅度,从而避免策略更新过大导致的不稳定问题。具体来说,PPO 在优化过程中通过比较新旧策略在同一状态下的行为概率比值,确保新策略不会偏离旧策略太远,同时仍然能够进行有效的优化。这种裁剪机制使得 PPO 能够在不需要复杂计算(例如信任区域优化)的情况下实现与更高级别算法(如 TRPO)相近的性能。此外,PPO 使用单独的价值模型来估计优势函数(Advantage Function),从而减少方差并提高策略评估的准确性。

Group Relative Policy Optimization (GRPO) 是一种新型强化学习算法,其核心目标是通过组内奖励归一化来优化策略,从而显著降低计算成本并提升训练效率。与传统方法(如 PPO)不同,GRPO 不依赖单独的价值模型,而是直接基于组内生成结果的相对奖励进行优化,这种方法消除了价值网络训练所需的大量计算资源和内存占用。在 GRPO 中,同一输入会生成多个输出,这些输出会被分配不同的奖励值,通过对这些奖励进行归一化计算相对优势,从而指导策略更新。此外,GRPO 将新旧策略之间的差异直接作为正则化项加入损失函数中,而不是像 PPO 那样通过间接奖励惩罚实现正则化。这种直接正则化机制简化了训练流程,同时确保了模型生成结果的一致性和质量。

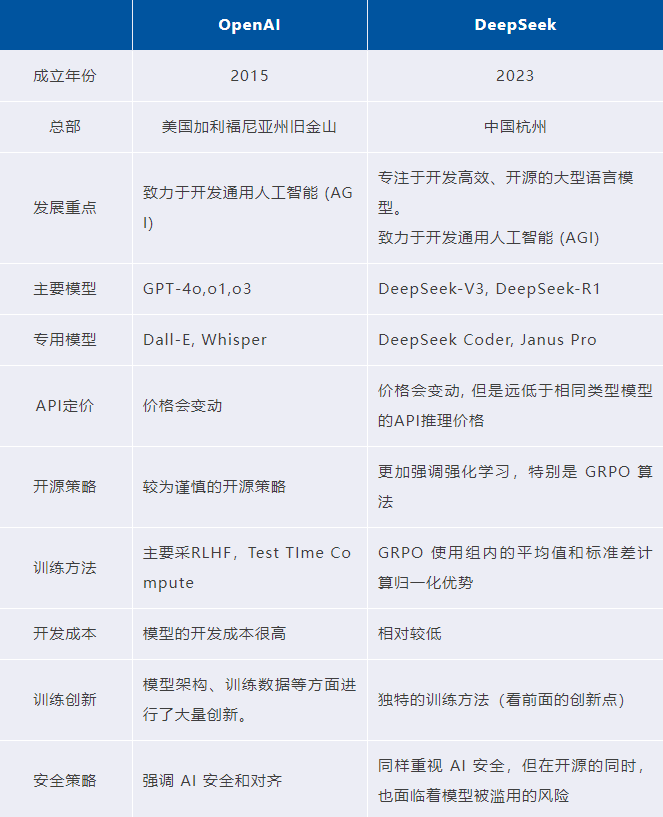

DeepSeek 与 OpenAI 的比较

在人工智能领域,DeepSeek 和 OpenAI 是两家备受瞩目的技术领导者,它们的模型在性能、成本、灵活性和市场定位等方面各具特色。虽然 OpenAI 以其封闭但高度优化的生态系统闻名,DeepSeek 则凭借开源策略和高性价比迅速崭露头角。

生成式AI安全现状及对行业的安全建议

生成式AI安全现状分析

生成式AI技术在近年来的飞速发展,带来了前所未有的创新突破。各大模型公司相继推出的大规模语言模型(LLM)如DeepSeek、OpenAI的GPT系列,不仅在自然语言处理、机器翻译、图像生成等领域表现出强大的能力,还推动了多个行业的进步。然而,随着这些技术的迅速普及,安全问题也随之而来,尤其体现在以下几个方面:

1. 数据安全风险加剧

- 训练数据污染事件频发:2023年Meta因第三方数据供应商的恶意数据注入,导致其开源模型Llama 3在金融领域出现系统性偏见。

- 用户隐私泄露呈指数级增长:美国联邦贸易委员会(FTC)数据显示,2024年上半年AI相关数据泄露事件同比增加217%。

- 多模态数据安全边界模糊:图像生成模型Stable Diffusion XL被证实可通过逆向工程反推训练数据中的敏感图像。

2. 模型安全威胁升级

- 对抗攻击成功率持续攀升:MITRE实验室测试显示,主流大模型的提示注入攻击防御成功率不足60%。

- 模型窃取攻击产业化:黑市出现"Model Cloning as a Service"服务,可通过API侧信道攻击复现商业模型核心参数。

- 开源模型滥用常态化:HuggingFace平台检测到23%的开源模型被恶意修改后用于网络钓鱼内容生成。

3. 合规压力持续增强

- 全球监管框架密集出台:欧盟《AI法案》将基础模型列为"系统性风险",中国《生成式AI服务管理暂行办法》建立全生命周期监管。

- 行业标准碎片化严重:NIST AI RMF、ISO/IEC 23894等标准在安全评估方法上存在技术分歧。

- 跨境数据流动限制加剧:多国将模型训练数据纳入数据主权管辖范围,导致跨国企业合规成本激增。

4. 供应链风险复杂化

- 第三方组件漏洞呈链式传播:PyTorch生态中的TorchServe漏洞影响超过80%基于该框架的大模型服务。

- 硬件供应链威胁凸显:2024年某AI芯片被曝存在设计后门,可导致模型参数泄露。

- 开源社区信任危机:GitHub统计显示,AI项目依赖库的恶意代码植入事件年增长率达340%。

这些安全挑战的交叉叠加,使得大模型公司正面临"技术发展-安全投入-合规成本"的三元悖论。建立系统化的安全防护体系已成为行业可持续发展的必选项。

面向大模型公司的安全体系构建建议

在生成式AI技术快速发展的背景下,参考《Generative AI Security》一书所提供的全面框架,我们建议从以下几个方面构建完整的安全防护体系。该书由云安全联盟大中华区,世界数字科学院和全球顶级的AI和安全公司包括高校共同写作完成。2024年由权威的科技出版社Springer出版。

安全治理框架建设

首要任务是建立专门的AI安全治理委员会,负责制定AI安全战略和政策。该委员会应由技术、安全、法务、合规等跨部门人员组成,定期评估AI安全风险,制定相应的管控措施。同时,建议参考《Generative AI Security》中的安全计划框架,建立包含风险评估、安全控制、监控审计等环节的全流程安全管理体系。

数据安全防护体系

数据作为AI模型的基础,其安全性直接影响模型的可靠性。建议建立完整的数据安全生命周期管理制度:首先,实施数据分类分级制度,对不同敏感程度的数据采取差异化保护措施;其次,建立数据访问控制机制,实施最小权限原则;第三,实施全流程数据加密方案,包括传输加密、存储加密和计算加密;最后,建立数据泄露检测和响应机制,及时发现和处理数据安全事件。

模型安全保障机制

针对模型安全,需要建立多层次的保护机制:在训练阶段,实施严格的数据清洗和验证流程,防止训练数据污染;在部署阶段,建立模型完整性校验机制,防止未经授权的模型修改;在运行阶段,实施实时监控和异常检测,及时发现异常行为。同时,定期开展模型安全评估,包括对抗样本测试、模型鲁棒性测试等。

应用安全防护措施

在应用层面,需要特别关注API安全和提示词注入防护:实施严格的API认证和授权机制,限制API调用频率和范围;建立输入验证和输出过滤机制,防止恶意提示词攻击;实施应用级别的安全监控,记录和分析异常访问行为;定期开展应用安全测试,及时发现和修复安全漏洞。

安全运营体系建设

参考《Generative AI Security》中的LLMOps和DevSecOps最佳实践,建立统一的安全运营体系:首先,建立专门的AI安全运营团队,负责日常安全监控和响应;其次,实施自动化的安全检测和响应机制,提高安全运营效率;第三,建立安全事件响应预案,定期开展应急演练;最后,建立安全度量体系,定期评估安全措施的有效性。

合规与风险管理

密切关注全球AI监管趋势,确保DeepSeek的应用符合相关法规要求:建立AI合规审查机制,定期评估合规风险;制定AI伦理准则,确保AI应用的透明性和可解释性;建立隐私保护机制,保护用户数据安全;定期开展第三方安全评估,及时发现和处理潜在风险。

能力建设与持续改进

安全建设是一个持续改进的过程,建议:定期组织AI安全培训,提升团队安全意识和技能;建立安全知识库,沉淀安全经验和最佳实践;参与行业安全交流,及时了解最新安全威胁和防护技术;定期评估安全建设成效,持续优化安全措施。

DeepSeek 对网络安全的影响

在生成式AI技术面临系统性安全挑战的背景下,DeepSeek的创新实践为行业提供了技术演进与风险防控的典型样本。其模型架构、部署模式和开源策略的独特性,既放大了既有安全威胁的传导效应,也为构建新型防御体系提供了技术试验场。具体影响体现在三个关键维度:

模型架构对安全防御的启示与挑战

DeepSeek的模型架构设计中,大规模参数量和深度网络结构为其赋予了强大的学习与推理能力,但也使得其在安全防护方面面临更加复杂的挑战。首先,深度神经网络的复杂性使得其在面对未知攻击时的鲁棒性较弱。攻击者可以利用对抗样本技术,轻微修改输入数据,就能成功欺骗AI系统。其次,模型内部的“黑箱”特性使得AI决策的透明度和可解释性较低,导致网络安全事件的根源追踪变得更加困难。因此,尽管DeepSeek能够提供强大的智能决策能力,但其内部的漏洞和隐患依然是安全防御体系中不可忽视的部分。

然而,DeepSeek的架构设计也为新型防御体系的建立提供了借鉴。通过模型可解释性增强、对抗训练和安全性集成等手段,DeepSeek不仅能够提升对抗攻击的防御能力,还能为未来的AI安全技术发展提供重要的实验平台和思路。

部署模式的安全性考量

DeepSeek的部署模式,不仅限于传统的云端服务,还大力推动了边缘计算和本地化部署的普及。这一模式在提供实时响应和本地数据处理优势的同时,也带来了新的安全隐患。尤其是在边缘设备的部署中,计算资源和存储空间的限制往往导致安全功能的精简或弱化。攻击者可以利用边缘设备的物理访问权限,实施更为隐蔽的攻击,例如通过硬件级别的漏洞进行信息窃取或篡改模型输出。

此外,分布式部署模式带来的网络通信复杂性,也使得数据传输过程中的安全风险加剧。例如,模型在不同节点间的数据交互可能暴露在不安全的网络环境中,成为中间人攻击(MITM)和数据篡改的潜在目标。为此,加强边缘设备的安全防护、采用端到端加密技术,并在部署时执行严格的安全审计,成为应对这类挑战的必要措施。

DeepSeek 开源策略的双重影响

开源策略带来了显著的优势。首先,代码的透明性有助于快速发现和修复安全漏洞。其次,全球开发者社区的协作推动了安全技术的创新和进步。同时,开放的代码审查机制提高了模型的可信度和安全性。

但开源也带来了一些潜在风险。源代码的公开可能使攻击者更容易发现和利用漏洞。恶意开发者可能对代码进行修改,植入后门或其他有害功能。知识产权保护成为一个重要问题,需要在开放性和专有技术保护之间取得平衡。此外,开源项目的长期维护和安全更新也需要持续的投入和支持。

面对这些挑战,建立完善的安全管理框架变得尤为重要。这包括制定严格的安全策略、建立有效的监控机制、培训专业的安全团队,以及与社区保持密切协作。只有这样,才能充分发挥DeepSeek的优势,同时有效控制相关风险。

结论

DeepSeek 是一家新兴的人工智能公司,其核心创新和安全影响值得关注。

在技术创新方面,DeepSeek 开发了独特的组相对策略优化(GRPO)方法,这种方法不需要单独的评估模型,显著提高了训练效率。公司还在 DeepSeek V3 中引入了多头潜注意力(MLA)和多令牌预测(MTP)技术,进一步优化了模型性能。其训练方法包括纯强化学习训练(DeepSeek-R1-Zero)和多阶段训练流程,展现了与传统方法不同的技术路线。

与 OpenAI 相比,DeepSeek 采用更开放的开源策略,开发成本相对较低。公司更强调强化学习技术,特别是 GRPO 算法的应用。在商业模式上,DeepSeek 的 API 定价较低,具有明显的价格优势。

此外,数据泄露、越狱攻击以及代码生成安全隐患,这些都是当前大模型开发与运营过程中亟需解决的普遍安全问题。因此,AI提供者和运营者应当加强对这些安全风险的识别和防范,制定完善的安全策略和机制,确保在推动技术创新的同时,能够有效保护用户数据和系统安全。

在探讨了DeepSeek的技术创新及其对网络安全的影响后,我们不难发现,随着生成式AI技术的快速发展,AI安全已成为一个至关重要的议题。为了应对这一挑战,云安全联盟大中华区推出了人工智能安全认证专家(Certified Artificial Intelligence Security Professional,CAISP)认证培训项目。旨在为从事AI及其安全的研究、管理、运营、开发以及网络安全等领域的专业人员提供一套全面覆盖AI安全领域的认证培训。其课程内容侧重于跨领域综合能力培养、实践导向与案例分析,并融合了全球视野与法规治理,从而提升学员在AI安全领域的综合技能。

CAISP学员对象:AI安全工程师、AI工程师与开发者、政策制定者和监管机构、网络安全从业者、安全研究员、合规与风险管理人员、AI行业从业人员、在校学生、AI应用终端用户及所有感兴趣的学员。

登录

登录

雷池WAF

雷池WAF 安恒信息

安恒信息